- Windows ML unifica la ejecución local de modelos de IA en PCs con Windows, optimizando hardware y facilitando el desarrollo.

- La integración de ONNX Runtime y los proveedores de ejecución de AMD, NVIDIA, Intel y Qualcomm aseguran máxima compatibilidad y rendimiento.

- Está pensado para proteger la privacidad, reducir costes y permitir el uso de IA sin conexión a Internet.

Windows ML está redefiniendo la integración de la inteligencia artificial en el sistema operativo más extendido del mundo, abriendo nuevas posibilidades tanto para desarrolladores como para usuarios finales. El avance de la IA ha llevado a Microsoft a apostar fuerte por crear un entorno que permita ejecutar modelos de aprendizaje automático de forma local y eficiente en los PCs con Windows, aprovechando al máximo el hardware disponible. Si te preguntas en qué consiste exactamente Windows ML, cómo funciona, qué ventajas aporta frente a otras soluciones, o cómo puede transformar el desarrollo y uso de software en ordenadores personales, aquí tienes la guía más completa y actual en español para entenderlo al detalle.

El auge de la IA está ya en nuestras casas, y lejos de limitarse a la nube o a dispositivos especializados, ahora puede trabajar directamente desde tu propio equipo. Windows ML llega como un framework robusto y versátil, facilitando que tanto grandes empresas como pequeños desarrolladores integren funciones de inteligencia artificial avanzadas de manera sencilla y optimizada. Vamos a desgranar todo lo importante sobre esta plataforma, desde sus puntos técnicos hasta su impacto práctico en la vida diaria y en el desarrollo de software.

Índice

- 1 ¿Qué es Windows ML?

- 2 El papel clave de ONNX y ONNX Runtime

- 3 ¿Cómo funciona Windows ML?

- 4 Ventajas prácticas de Windows ML para usuarios y empresas

- 5 Requisitos de sistema y compatibilidad

- 6 ¿Qué es un proveedor de ejecución (Execution Provider, EP)?

- 7 Integración con el ecosistema de inteligencia artificial en Windows

- 8 Cómo empezar: instalación y primeros pasos

- 9 Conversión y optimización de modelos para ONNX

- 10 Casos de uso y ejemplos prácticos

- 11 Comparativa y evolución respecto a DirectML

- 12 Por qué es relevante para empresas y desarrolladores

- 13 Actualizaciones y futuro de Windows ML

¿Qué es Windows ML?

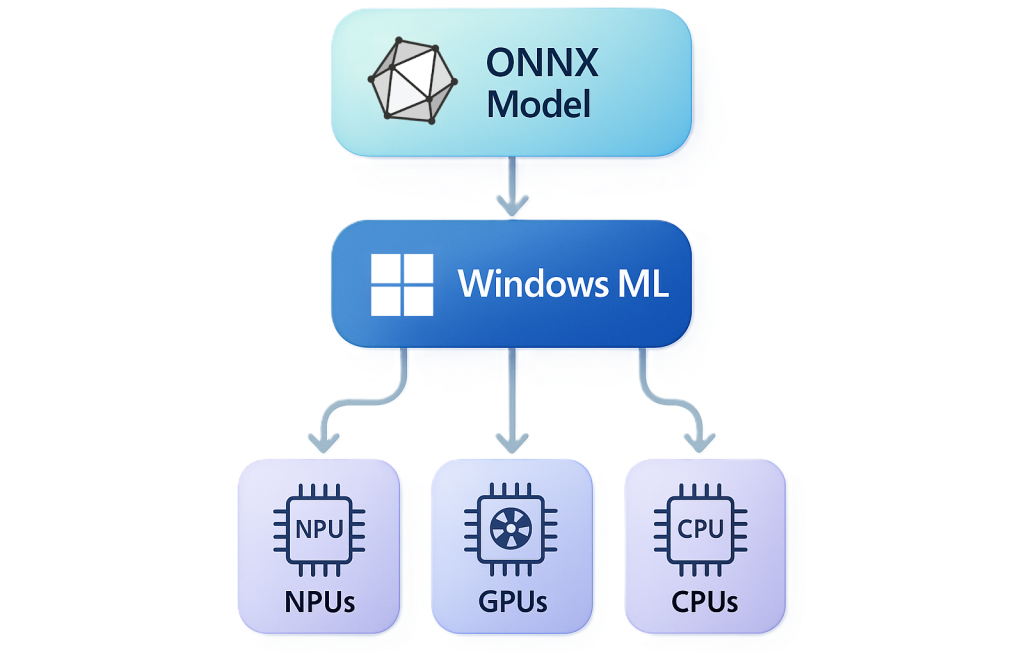

Windows ML (Machine Learning para Windows) es una plataforma de inteligencia artificial integrada en Windows 11 y, anteriormente, en Windows 10, cuyo objetivo es permitir a los desarrolladores ejecutar modelos de aprendizaje automático en equipos Windows de manera local, rápida y segura. Para ello, se apoya en ONNX Runtime y en un sistema de proveedores de ejecución (Execution Providers, EPs) que optimizan el uso del hardware concreto de cada PC.

Uno de los elementos diferenciales de Windows ML es su capa de abstracción de hardware, que facilita la ejecución de modelos de IA en las distintas arquitecturas (CPU, GPU o NPU) presentes en el mercado de PC, sin que el usuario o el desarrollador tengan que preocuparse por los detalles técnicos de bajo nivel. En esencia, Windows ML unifica el acceso a los recursos de hardware para ofrecer siempre el mejor rendimiento disponible, adaptándose a cada máquina.

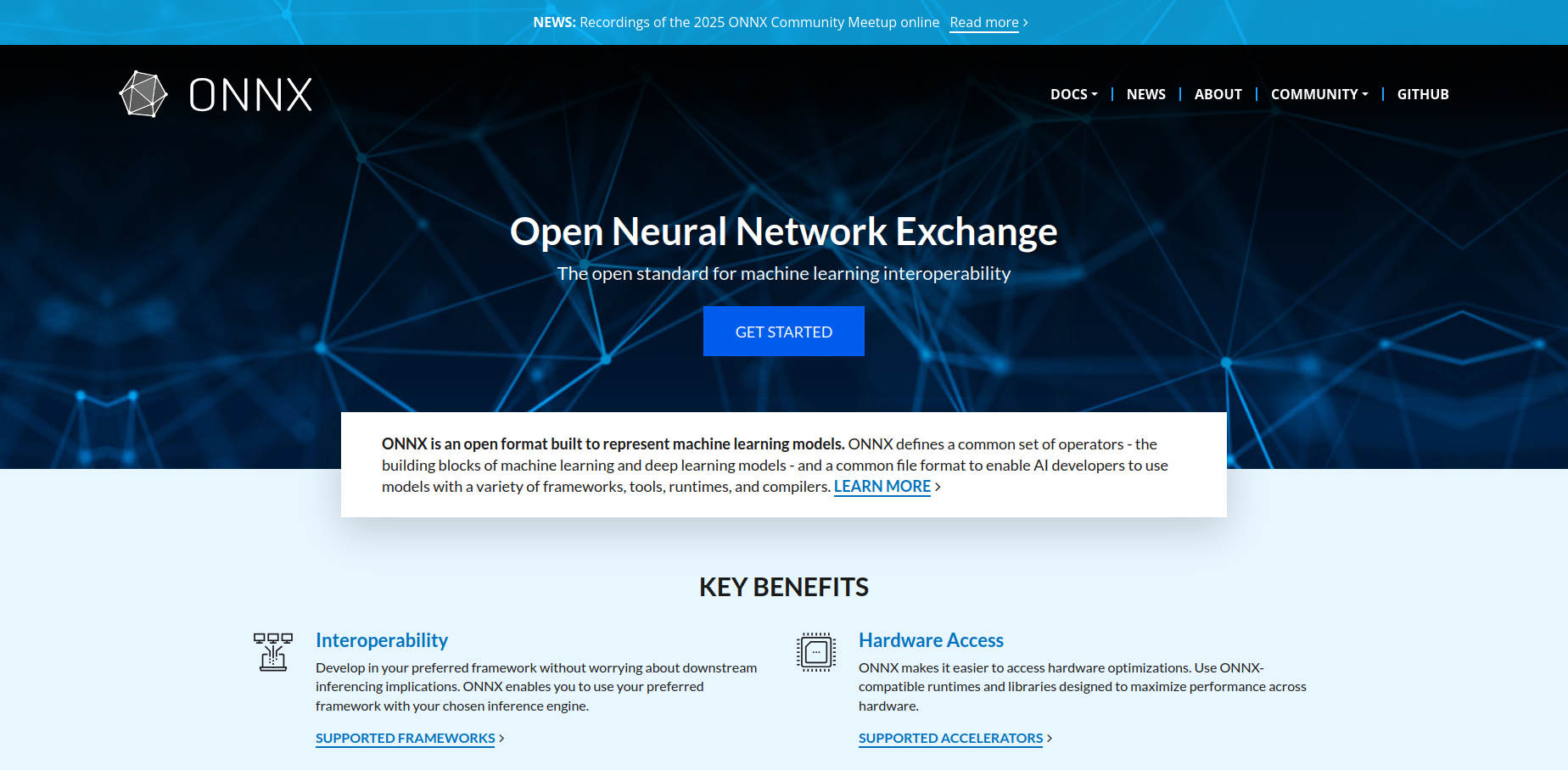

El papel clave de ONNX y ONNX Runtime

La compatibilidad con modelos en formato ONNX (Open Neural Network Exchange) es central en Windows ML. Este formato abierto se ha convertido en el estándar para la interoperabilidad de modelos de IA entre diferentes frameworks y plataformas. Gracias a ONNX Runtime, Windows ML puede ejecutar modelos desarrollados en otras herramientas como PyTorch, TensorFlow/Keras, TFLite o scikit-learn sin necesidad de reentrenarlos o ajustarlos a un entorno específico de Windows.

Además, ONNX Runtime permite que diferentes proveedores de hardware desarrollen sus propios EPs (Execution Providers), optimizando la inferencia y el rendimiento para CPUs, GPUs o NPUs concretas. Por ejemplo, fabricantes como AMD, Intel, NVIDIA o Qualcomm cuentan con sus propios EPs para sacar el máximo partido de sus chips en el ecosistema Windows.

¿Cómo funciona Windows ML?

El funcionamiento interno de Windows ML puede resultar complejo a nivel técnico, pero desde la perspectiva del usuario y del desarrollador, lo más importante es que gestiona automáticamente qué parte del hardware ejecuta cada modelo de IA. Esto significa que no necesitas conocimientos avanzados para aprovechar la aceleración por GPU o NPU: el sistema lo hace por ti.

- Instalación y detección de hardware: Al instalar una aplicación que utiliza IA con Windows ML, el sistema detecta qué procesadores (CPU, GPU, NPU) tiene el equipo.

- Descarga automática de proveedores de ejecución: Windows ML descarga y mantiene actualizados los EPs más adecuados para el hardware disponible, todo de forma desatendida.

- Ejecución de modelos: Los modelos de IA se ejecutan optimizados para el hardware, ofreciendo máxima velocidad y eficiencia energética.

Esta arquitectura elimina la necesidad de que los desarrolladores gestionen manualmente las dependencias, actualizaciones o compatibilidades de diferentes tipos de hardware, simplificando enormemente el desarrollo de software de IA en Windows.

Ventajas prácticas de Windows ML para usuarios y empresas

- Máximo rendimiento local: Al usar el hardware del propio PC, se mejora la velocidad y se reducen los costes frente a soluciones en la nube.

- Confidencialidad y protección de datos: Ejecutar modelos en local evita problemas de privacidad, ya que los datos no tienen que salir del equipo.

- Uso sin conexión: Puedes beneficiarte de la IA incluso sin conexión a Internet, algo esencial para entornos seguros o situaciones de movilidad (por ejemplo, en vuelos).

- Compatibilidad garantizada: Funciona en cualquier configuración de hardware compatible con Windows 11 (x64 y ARM64), desde portátiles básicos hasta workstations de alto rendimiento.

- Reducción del tamaño de las apps: La compartición del runtime de ONNX en todo el sistema permite que las aplicaciones sean más ligeras, ya que no incluyen cada una su propio entorno de ejecución y drivers.

Requisitos de sistema y compatibilidad

Para disfrutar de Windows ML necesitas cumplir una serie de requisitos mínimos:

- Sistema operativo: Windows 11 versión 24H2 (compilación 26100) o superior.

- Arquitectura: Compatible con procesadores x64 o ARM64.

- Hardware: Cualquier configuración de PC, con CPU, GPU integradas o discretas, o NPU dedicada.

Esto sitúa a Windows ML en la vanguardia para la generación actual de ordenadores, aunque también se han explorado versiones parciales o previas en Windows 10.

¿Qué es un proveedor de ejecución (Execution Provider, EP)?

El concepto de EP es fundamental en Windows ML. Son módulos que actúan como «puentes» entre el entorno de ejecución de ONNX y el hardware específico (CPU, GPU, NPU). Básicamente, los EPs permiten que una misma aplicación aproveche las optimizaciones de cada chip sin cambiar ni una línea de código.

Microsoft ha colaborado con los principales fabricantes de semiconductores para garantizar EPs actualizados y eficientes. Por ejemplo:

- AMD: Ofrece soporte avanzado a través de Ryzen AI para CPU, GPU y NPU.

- Intel: Integra su conocido OpenVINO para sacar partido a CPUs, GPUs y NPUs en los Intel Core Ultra.

- NVIDIA: Proporciona TensorRT for RTX para ejecutar modelos de IA en tarjetas RTX y RTX Pro.

- Qualcomm: Utiliza Qualcomm Neural Network EP para SnapDragon X, optimizando la NPU y la integración con otros componentes.

Esto asegura que, independientemente de la marca de tu equipo, Windows ML pueda aprovechar toda la potencia disponible.

Integración con el ecosistema de inteligencia artificial en Windows

Windows ML es más que una herramienta aislada, forma la base para una integración profunda de la IA en Windows. Actualmente, se conecta con otros servicios y herramientas como:

- Windows AI API: facilitan el uso de modelos para tareas comunes sin apenas barrera técnica.

- Foundry Local: proporciona modelos listos para usar en escenarios típicos.

- Modelos personalizados: permite acceso avanzado mediante la API de Windows ML para soluciones a medida.

- Visual Studio Code AI Toolkit: centraliza la conversión, optimización y despliegue de modelos ONNX desde frameworks populares como PyTorch, incluyendo herramientas de cuantización y evaluación.

Todo este ecosistema está diseñado para que tanto desarrolladores individuales como grandes empresas puedan integrar la inteligencia artificial en sus productos de forma ágil y escalable.

Cómo empezar: instalación y primeros pasos

Para quienes quieran adentrarse en el desarrollo con Windows ML, los pasos básicos son:

- Instala o actualiza el Windows App SDK a la versión 2.0.0 o posterior. Este SDK incluye las APIs necesarias para trabajar con Windows ML.

- Permite que Windows ML detecte y descargue automáticamente los proveedores de ejecución compatibles con tu hardware. La función

EnsureAndRegisterCertifiedAsync()facilita todo el proceso en un solo paso. - Selecciona los proveedores de ejecución que más te interesen y obtén los modelos deseados, ya sea desde catálogos online o integrándolos localmente en tu proyecto.

Después de estos pasos, puedes cargar tus modelos ONNX y comenzar la inferencia de IA en local, disfrutando de toda la potencia de tu equipo Windows.

Conversión y optimización de modelos para ONNX

Si tienes modelos de IA en otros formatos (PyTorch, TensorFlow, Hugging Face, etc.), puedes convertirlos fácilmente a ONNX utilizando herramientas como el AI Toolkit para VS Code. Este paso es fundamental para desplegar modelos en Windows ML. Además, hay amplia documentación y tutoriales disponibles en Microsoft Learn para ayudarte en este proceso, incluyendo tareas de cuantización y optimización para asegurar el mejor rendimiento.

Las aplicaciones pueden gestionar modelos tanto en local (empaquetando los archivos en la app) como a través de catálogos online, eliminando la necesidad de descargar grandes ficheros si solo se necesita un modelo específico para una tarea concreta.

Casos de uso y ejemplos prácticos

Grandes nombres del software ya están utilizando Windows ML para añadir funciones inteligentes a sus aplicaciones de escritorio. Algunos ejemplos destacados:

- Adobe: Integra IA en funciones como generación automática de subtítulos en Premiere Pro.

- Topaz Labs: Usa modelos para reducir el ruido en imágenes mediante Denoise.

- McAfee: Implementa la detección de Deepfakes en vídeos.

- Bufferzone: Añade alertas de phishing en navegación web.

- Camo: Permite realizar vídeos inteligentes con IA usando la webcam del usuario.

Estas aplicaciones demuestran que la IA local ofrece ventajas en velocidad, privacidad y personalización que no se pueden igualar únicamente con IA en la nube.

Comparativa y evolución respecto a DirectML

Si te suena DirectML, debes saber que Windows ML es su evolución natural. Ha sido creado «escuchando» las necesidades de la comunidad de usuarios y desarrolladores, incorporando nuevas funciones, mejor compatibilidad y un rendimiento superior en tareas de aprendizaje automático. Desde ahora, Windows ML es el estándar, integrando además el soporte para ONNX Runtime Engine y maximizando la colaboración con la industria del hardware.

Por qué es relevante para empresas y desarrolladores

La IA está cada vez más presente en nuestro día a día, y Windows ML acerca estas capacidades tanto a pymes como a grandes corporaciones. Permite crear software más potente y sensible al contexto, optimizando tareas como análisis de imágenes, vídeos, voz y datos estructurados en local. La ejecución en local brinda mayor control y menor riesgo de seguridad en sectores críticos como la salud, finanzas o administración pública.

Actualizaciones y futuro de Windows ML

Microsoft mantiene una política activa de actualizaciones continuas tanto para Windows ML como para los proveedores de ejecución propio y de terceros, en colaboración con los fabricantes de hardware. Esto asegura que, a medida que salen nuevos chips y tecnologías, los usuarios y desarrolladores puedan beneficiarse de las últimas funcionalidades y optimizaciones automáticamente, sin tener que reinstalar ni modificar sus aplicaciones.

El crecimiento de la computación local en IA y la integración de nuevas tecnologías auguran un desarrollo todavía mayor de este ecosistema, consolidando a Windows ML como pieza clave en el futuro de la inteligencia artificial en dispositivos Windows.

Windows ML se consolida como el puente definitivo entre el desarrollo de IA puntero y el usuario doméstico y profesional, democratizando el acceso a funciones avanzadas y simplificando tanto su integración como su rendimiento en cualquier máquina. Tanto si eres desarrollador, responsable de TI o simplemente usuario curioso, Windows ML representa una pieza fundamental en el presente y en el futuro de la tecnología personal.

[relacionado url=»https://www.tecnoloblog.com/que-es-windows-server/»]